En surface, la bataille autour de l'intelligence artificielle se joue dans la course aux applications de demain. Assistants vocaux, reconnaissance d'image, analyse prédictive, aide au diagnostic médical... L'IA a déjà commencé à révolutionner de nombreuses industries. Pour imposer ces nouveaux outils, les géants de la tech américains et chinois s'arrachent les meilleurs chercheurs. Mais derrière la bataille des applications se joue une autre guerre, moins visible mais cruciale : celle du matériel qui fait tourner l'IA. En tout, le marché de l'équipement des datacenters pesait 210 milliards de dollars en 2018, d'après le cabinet de conseil Gartner. Au sein des serveurs qui alimentent ces centres de données, l'élément clé est un processeur qui accélère l'intelligence artificielle : la Graphic Processing unit (GPU).

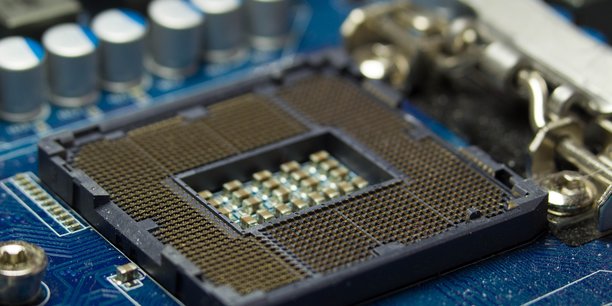

Une puce carrée de quelques millimètres de large et de longueur. Les serveurs les plus performants en connectent plusieurs pour obtenir davantage de puissance de calcul. Un marché spécifique à l'IA que se partagent en duopole les américains Nvidia et Advanced Micro Devices (AMD). Le premier en est le champion incontestable : il pèse, selon les trimestres, entre 65 % et 80 % de parts de marché à lui seul. Mais les prétendants se bousculent au portillon. Intel, Google, Microsoft, IBM, Amazon, Facebook, Baidu ou encore Huawei planchent sur un processeur alternatif, capable de détrôner le GPU. Des startups comme GraphCore, Wave Computing ou Cerebras lèvent aussi des centaines de millions de dollars, persuadées de pouvoir créer une puce mieux adaptée que le GPU à l'intelligence artificielle de demain.

Nvidia, pionnier toujours premier

Avant l'essor de l'intelligence artificielle, au début des années 2010, la puissance de calcul des ordinateurs s'appuyait principalement sur les processeurs CPU, appelés aussi unités centrales. Très performants pour effectuer des calculs les uns après les autres, les CPU ne sont pas adaptés à l'IA. Car ses méthodes d'apprentissage machine et profond nécessitent de pouvoir effectuer des milliards de calculs en même temps. C'est pourquoi l'IA, qui existe depuis les années 1950, a stagné jusqu'à la fin des années 2000. À ce moment, des scientifiques réalisent, par hasard, que les GPU de Nvidia, réputés surtout pour le traitement de l'image, savent aussi effectuer les calculs de machine learning et de deep learning. Grâce au GPU, les chercheurs peuvent enfin faire tourner les algorithmes qu'ils développent depuis des années. Heureuse surprise pour Nvidia et AMD, qui voient s'ouvrir un tout nouveau marché, en plus de celui des jeux vidéo et du graphisme 3D qui avaient fait leur renommée mondiale.

Le succès de Nvidia est dû en partie à son interface agnostique, qui permet à tous les algorithmes, peu importe leur langage de développement - et il y a en beaucoup -, de fonctionner sur son matériel. Une manière d'éviter la guerre du logiciel et de démocratiser l'utilisation de ses processeurs. Cette stratégie a porté ses fruits : en 2018, la division de l'entreprise consacrée aux puces destinées aux datacenters pesait à elle seule 2,9 milliards de dollars de chiffre d'affaires annuel, soit plus du double que deux ans auparavant. Le département représente 24,8 % du chiffre d'affaires global du groupe et est amené à devenir son activité principale à moyen terme.

Les GPU, pas assez puissantes ?

Si les GPU dominent aujourd'hui le marché des puces d'IA, leurs limites commencent à apparaître. « Quand on s'intéresse à des problèmes comme la conception des médicaments, on observe qu'ils ne sont pas encore solvables avec les processeurs actuels », explique Jerry Yang, General Partner de l'incubateur et fonds d'investissement Hardware Club. L'une de ces limites est que « les GPU ne peuvent pas accéder à beaucoup de mémoire, souligne l'investisseur. Mais la majorité des entreprises doivent les utiliser car il n'y a pas d'autre solution. »

Pour aller au-delà des capacités des GPU, les autres constructeurs se sont lancés dans le développement de processeurs spécialisés dans certains types de calculs. On les appelle ASIC. Chacun d'entre eux doit exceller dans un type d'intelligence artificielle, et ainsi calculer plus vite tout en dépensant moins d'énergie. L'objectif : court-circuiter les GPU généralistes en jouant l'hyper-spécialisation. Google a dégainé en premier en 2016, avec ses dant moins d'énergie. Mais pour d'autres usages, le groupe californien ne peut pas encore se passer des GPU. D'ailleurs, il ne souhaite pas les concurrencer, du moins pour l'instant. Compatibles uniquement avec l'environnement de travail de Google, TensorFlow, les TPU ne sont pas commercialisés. Pour les utiliser, un seul moyen : louer un serveur cloud de Google.

Une dizaine de nouveaux acteurs

À la Hot Chips, la conférence annuelle des acteurs du secteur qui s'est tenue mi-août, Intel, le leader des processeurs grâce à ses CPU, a enfin dévoilé ses puces spécialisées pour l'IA, développées en partenariat avec Baidu. Les « processeurs à réseaux neuronaux » d'Intel se déclinent en deux gammes : l'une pour entraîner les intelligences artificielles (NNP-T), l'autre pour faire tourner les modèles (NNP-I). Le constructeur les a baptisés Nervana, du nom de la startup spécialisée qu'il a racheté pour 408 millions de dollars en 2016. Ces puces devraient logiquement s'imposer comme les plus grands concurrents des GPU pour équiper les futurs datacenters. Mais elles ne seront pas les seules à tenter ce pari. À cette même conférence, la startup américaine Cerebras a surpris avec son processeur 56 fois plus large que la plus grande des GPU, et espère désormais prouver l'efficacité de sa puce.

Une semaine après, Huawei a dévoilé son processeur, alors que Amazon Web Services avait fait de même fin 2018. Alerté par cette concurrence, Nvidia développe de nouvelles architectures de GPU spécialisées. Le nombre de références sur le marché va se multiplier avec l'entrée d'une dizaine de nouveaux acteurs, avec de la place pour presque tout le monde. « À long terme, il y aura différents processeurs à utiliser selon les différents cas », prédit Jerry Yang. « Il faut comprendre que l'efficacité des processeurs dépend beaucoup du nombre de données et du type de données qu'on veut utiliser », ajoute-t-il. Aujourd'hui, les data scientists passent beaucoup de temps à préparer les données pour qu'elles puissent être modélisées. Demain, les nouveaux processeurs pourraient s'adapter à tout type de données, et faire gagner beaucoup de temps.

Plan d'urbanisme à Paris : les professionnels dénoncent « une aberration », le premier adjoint d'Hidalgo leur répond

Plan d'urbanisme à Paris : les professionnels dénoncent « une aberration », le premier adjoint d'Hidalgo leur répond

Sujets les + commentés