Il y a un an, jour pour jour, « l'agent conversationnel » sud-coréen Lee Luda (on utilise plus communément l'anglicisme de « chatbot » pour désigner ces machines qui interagissent en langage naturel à l'écrit comme à l'oral.) défrayait la chronique. Lancé quelques semaines plus tôt, ce chatbot avait réussi à rassembler près de 750.000 utilisateurs séduits par cette voix capable de faire ami-ami avec ses interlocuteurs humains.

Bref, le compagnon idéal avec qui, en confiance, on aime papoter et se confier. Ce rêve de la machine empathique dura... moins de 30 jours. Quelques semaines après son lancement, les concepteurs de Lee Luda durent se résoudre à déconnecter l'intelligence artificielle qui animait les conversations après que cette dernière ne perde les pédales en répondant à certains de ses utilisateurs par des messages sexistes ou ouvertement racistes[1]. Scatter Lab, le concepteur de ce chatbot, se fendit de plates excuses expliquant que l'intelligence artificielle qui avait servi à développer cet agent conversationnel devait être « éduquée pour qu'elle exerce son jugement sur les réponses qui sont appropriées, plutôt que d'apprendre sans discernement[2] ».

Cernés par les chatbots

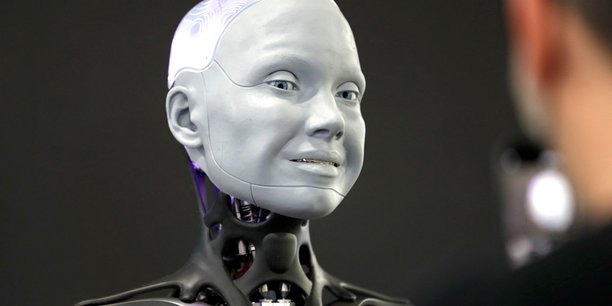

C'est un fait, nous vivons entourés d'écrans connectés et de systèmes boostés à l'intelligence artificielle capables de communiquer avec nous en « langage humain », au point parfois de ne plus savoir qui parle : humains ou machines ? (Il n'y a qu'à voir les traits du visage d'Ameca, le dernier-né du britannique Engineered Arts, affichant par exemple la surprise[3].) Les exemples radicaux de cette dépendance aux machines aux petits soins pour leurs « maîtres » sont connus : ici, un jeune Canadien qui, n'ayant pu se résoudre à la perte de l'être cher, se prend de passion pour un agent conversationnel avec lequel il communique sans cesse comme s'il s'adressait toujours à sa bien-aimée trépassée[4]. Dans des formes plus anodines, presque toutes les marques grand public se sont dotées de chatbots capables de converser avec leurs clients en prenant en charge leurs problèmes ou leurs multiples questionnements via un dialogue entre un ordinateur et des êtres humains.

Cette déferlante des agents conversationnels n'a pas manqué d'attirer l'attention des autorités et des régulateurs sur au moins deux sujets : d'une part, le recueil d'un très grand nombre de données personnelles qui, accumulées, permettent de cerner avec précision le profil des utilisateurs ainsi que leurs éventuelles faiblesses. Et d'autre part, conséquence du dernier point, la question éthique. Dans un avis rendu le 9 novembre dernier, le Comité national pilote d'éthique du numérique (CNPEN) mentionne que « les principales tensions concernent le brouillage des frontières entre une machine et un être humain, l'imitation du langage et des émotions par les chabots, ainsi que la capacité des agents conversationnels à manipuler les interlocuteurs humains.[5] »

Les 13 préconisations

L'avis du CNPEN propose aux industriels qui conçoivent ces agents conversationnels des principes de conception destinées à préconiser une stricte limitation de l'anthropomorphisation de l'agent conversationnel. En clair, et dans le process d'interaction « Homme-machine », il faudrait mentionner le plus tôt possible que l'agent conversationnel n'est pas une personne. Un principe apparemment évident, mais qui tend à s'effacer du fait que les chatbots imitent presque à la perfection les façons dont se conçoivent les dialogues entre humains, au point de brouiller tous les repères.

Dans le sillage de ce principe, 13 préconisations ont ainsi été formulées à l'adresse des autorités qui ont la responsabilité d'accroître l'effort de formation, d'éducation, mais aussi d'expérimentation à l'échelle de la société.

Dans le détail, ces préconisations portent sur de multiples aspects, dont la réduction de la projection spontanée de qualités morales sur ces machines, l'encadrement de l'usage des chatbots dans les jouets, le rappel que toute personne qui communique avec un agent conversationnel doit être informée qu'elle dialogue en fait avec une machine, le fait qu'un agent conversationnel ne doit pas répondre aux insultes (de l'humain) par d'autres insultes (celles-là éventuellement programmées dans le corpus d'apprentissage de ces machines), ou encore, l'idée qu'une réflexion éthique approfondie à l'échelle de toute la société devra être menée par le législateur concernant les agents conversationnels qui imitent la parole des personnes décédées.

Instruments de manipulation

De plus en plus performantes du fait des innovations logicielles embarquées en matière de traitement du langage tirés des applicatifs d'intelligence artificielle (technologies dites de « Natural Language Processing »), on perçoit les responsabilités de la relation humains-machines et ceci dans un contexte où cette dernière s'apparente à des « transformers », autrement dit des outils de traitement automatique qui s'appuient sur l'IA et ses millions de paramètres qui capturent les subtilités du langage.

Nous répondant, nous interpellant, nous sollicitant sans cesse, ces machines deviennent tout à la fois nos confidentes, voire nos meilleures « amies » qui, bien sûr, ne veulent que notre bien. Comme le prédit le psychiatre Serge Tisseron :

« Personne ne les confondra avec des humains, mais nous nous habituerons, à leur contact, à de nouvelles formes de relations qui modifieront peu à peu notre fonctionnement psychique et nos liens avec nos semblables[6]. »

Par extension, et sans faire preuve d'un pessimisme démesuré, cette omniprésence des machines fabriquées pour nous écouter et répondre à nos moindres sollicitations s'ancreront de plus en plus profondément dans notre quotidien. Ces machines pourraient alors se révéler non seulement de redoutables instruments pour manipuler nos émotions, mais, au-delà, nos pensées et nos comportements dès lors que nous leur ferons une confiance sans borne. Entourés de machines de compagnie, ces « anges gardiens » s'immisceront dans tous les interstices de nos vies sans que nous ayons toujours pleinement conscience de leur emprise tant elles seront à notre service en nous manifestant affection, bienveillance, écoute et... amour.

Hasard du calendrier, quelques jours après la parution de l'avis du Comité national pilote d'éthique du numérique, 193 États, sous l'égide de l'UNESCO, adoptaient à leur tour une recommandation pour une IA éthique et responsable[7]. Voilà les concepteurs de ces chatbots, nos meilleurs nouveaux « amis », prévenus.

___

NOTES

1 https://www.rfi.fr/fr/asie-pacifique/20210112-lee-luda-un-service-de-chat-sud-cor%C3%A9en-perd-les-p%C3%A9dales

2 https://newsdirectory3.com/scatter-lab-reveals-apology-i-wasnt-careful-about-data-management/

3 | VIDÉO Regardez Ameca, le robot humanoïde, dans sa première apparition publique (reportage de CNET publié le 6.01.2022, en anglais)

4 https://www.sfchronicle.com/projects/2021/jessica-simulation-artificial-intelligence/

5 https://www.ccne-ethique.fr/sites/default/files/cnpen_cpresseavis3-vf_0.pdf

6 https://www.lemonde.fr/idees/article/2021/12/29/serge-tisseron-les-machines-parlantes-pourraient-se-reveler-de-redoutables-instruments-de-manipulation_6107577_3232.html

7 https://news.un.org/fr/story/2021/11/1109412

Emploi : les vraies raisons des vagues de départs des salariés français

Emploi : les vraies raisons des vagues de départs des salariés français

Sujets les + commentés