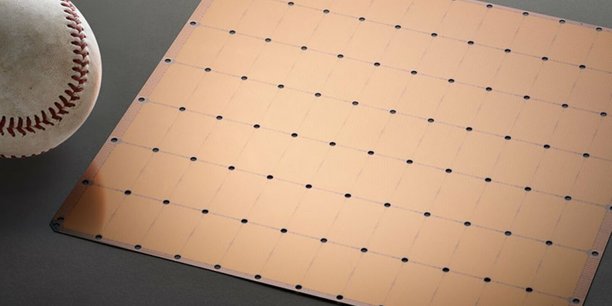

Une puce électronique de la taille d'un clavier peut-elle révolutionner la recherche en intelligence artificielle ? C'est en tout cas le pari pris par Cerebras System. La startup américaine a dévoilé mardi 20 août un nouveau modèle du genre, baptisé Cerebras WSE, à l'occasion de la conférence Hot Chips donnée à l'Université de Stanford (Californie).

Créées dans les années 60, les puces électroniques sont les cerveaux des ordinateurs : elles déterminent en partie leur capacité de calcul et leur rapidité. Ce sont de petits carrés - le plus souvent découpés sur des plaques de silicium - sur lesquels sont imprimés des circuits. Comme il est d'usage en tech, les ingénieurs ont toujours travaillé pour réduire progressivement les tailles des puces. L'intérêt : diminuer leurs besoins énergétiques, tout en permettant leur accumulation, pour créer des systèmes de plus en plus puissants.

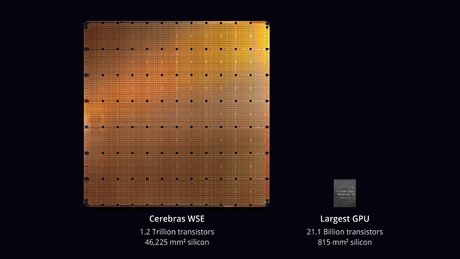

C'est pourquoi la puce de Cerebras, 56 fois plus grande que la plus large puce actuelle du marché, est inédite en son genre. Toutes ses caractéristiques établissent de nouveaux records. Elle compte 1,2 billion de transistors, 400.000 cœurs et 18 gigaoctets de mémoire. Conséquence : elle pourrait permettre d'entraîner des modèles d'intelligence artificielle plus rapidement et dans des proportions encore inégalées. Cerebras promet ainsi une capacité de traitement des données 150 fois plus rapide que les meilleurs serveurs du marché.

Malgré ces chiffres impressionnants, la startup a encore beaucoup à prouver. D'abord, il lui faut démontrer auprès des géants de la tech que sa puce unique en son genre est vraiment capable de traiter les données plus rapidement. Ensuite, elle devra rassurer sur sa capacité à produire son composant à une échelle industrielle.

La Cerebras WSE de 46 225 mm², placée à côté du plus grand GPU actuel, de 815 mm², produit par Nvidia.

Trouver la puce qui alimentera l'IA de demain

Les intelligences artificielles, et surtout l'apprentissage profond utilisé par exemple pour la reconnaissance d'image, s'avèrent particulièrement gourmandes en capacité de calcul. Dans sa phase d'entraînement, l'IA construit des modèles à partir de milliers, voire des millions de données qui lui sont fournies par les développeurs, grâce à autant de calculs redondants. En augmentant la capacité de calcul des puces, les constructeurs débloquent de nouvelles possibilités dans la recherche en IA.

"La révolution actuelle de l'apprentissage profond a été rendue possible par l'évolution du matériel. C'est le design du matériel, plus que celui des algorithmes, qui nous permettra de réaliser la prochaine avancée en IA", se projetait Bill Dally, le directeur scientifique de Nvidia, à l'occasion d'une conférence organisée par le MIT Technology Review en mars.

De nombreux algorithmes existaient déjà dès les années 1980, mais c'est grâce à l'accessibilité aux processeurs graphiques (ou GPU), à partir des années 2010, qu'ils ont pu être utilisés à grande échelle. A l'heure actuelle, les machines les plus performantes produites par Intel ou Nvidia embarquent, parmi d'autres composants, plusieurs GPU autour d'un ou plusieurs processeurs centraux. Cependant, les gains de vitesse de calcul réalisés par cet empilement de processeurs commencent à plafonner. L'industrie cherche donc la puce ou le processeur de demain, qui permettra de calculer toujours plus rapidement et ainsi élaborer de nouvelles IA.

Pour y parvenir, une des pistes les plus envisagées par les géants du secteur consiste à construire des puces spécialisées en apprentissage profond. Là où les GPU s'adaptent à différents types de calcul, ces puces nouvelle génération se spécialiseraient dans une seule tâche, comme l'apprentissage profond, mais y excelleraient. Elles permettraient des calculs plus rapides pour une tâche précise.

Une voie inédite sur le marché

Pour Cerebras, la méthode actuelle, qui consiste à connecter de nombreuses petites puces ensemble, a pour défaut de créer une latence qui ralenti l'entraînement des modèles d'intelligence artificielle. La startup, qui a levé 112 millions de dollars en trois ans d'existence, a donc suivi une autre voie : créer une puce unique, la plus grande et la plus puissante possible.

Les autres constructeurs ont écarté l'idée de créer une puce de cette taille en raison de ses risques de défaut. Dans la conception de puces classiques, un défaut peut engendrer la perte d'une petite partie des puces, mais le reste de la plaque de silicium sera fonctionnel. Dans le cas de Cerebras, si une simple impureté ou un petit écart vient perturber l'impression du circuit, c'est toute la plaque - et donc quelques dizaines de milliers de dollars - qui devient inutilisable. Puisque les transistors font une taille de l'ordre de la dizaine de nanomètres, et que la puce électronique de la jeune pousse en compte 1,2 billion, il est quasiment impossible de tous les graver sur la plaque sans erreur ou défaut.

Pour contourner ce verrou, Cerebras a créé sa propre méthode de conception. Sa puce est organisée en 84 tuiles, que l'on pourrait comparer à des puces individuelles, qui sont reliées entre elles. Chacune de ces tuiles dispose de composants similaires (notamment des cœurs de processeurs et de la mémoire) afin d'assurer une redondance. Ainsi, si une partie d'une tuile ne fonctionne pas, le circuit peut tout de même fonctionner grâce aux composants présents sur les autres tuiles.

Tout à inventer (dont un marché)

Cerebras est donc la première entreprise à parvenir à créer une puce de cette taille. Cette avance lui donne un avantage compétitif... et les problèmes qui vont de paire.

"Comment obtenir un connecteur qui puisse supporter cette puissance ? Personne ne l'a fait avant nous, nous avons donc dû l'inventer. Nous avons des docteurs en sciences des matériaux, et nous avons dû inventer un matériau qui puisse supporter la charge", a détaillé le CEO Andrew Feldman, interrogé par Techcrunch.

L'ensemble de l'écosystème est adapté à la production de puces de petite taille. En conséquence, la startup doit tout inventer si elle veut rendre son produit utilisable. Nouvelle méthode pour graver le processeur, nouveau logiciel pour le faire fonctionner, nouvelle méthode de réfrigération pour éviter sa surchauffe, nouvel emballage pour la protéger et la transporter... La startup a même conçu son propre ordinateur. Au-delà du composant, l'entreprise commercialisera tout un écosystème pour l'utiliser.

La Cerebras WSE a été conçue pour le traitement de très grandes bases de données, ce qui limite ses acheteurs potentiels aux géants de la data. Elle doit désormais convaincre les leaders du cloud, Amazon Web Services et Microsoft Azure en tête, de remplacer l'équipement de leurs data centers par ses puces. En dehors de la capacité de calcul, d'autres paramètres entreront alors en jeu dans l'équation : la consommation d'énergie du système, son entretien ou encore les domaines dans lesquelles la puce sera utile. D'après Techcrunch, Cerebras a déjà commencé à livrer des prototypes à ses premiers clients.

Emploi : les vraies raisons des vagues de départs des salariés français

Emploi : les vraies raisons des vagues de départs des salariés français

Sujets les + commentés