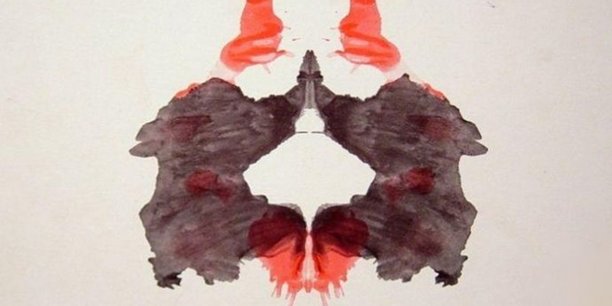

Connaissez-vous Norman ? C'est une IA psychopathe, nommée ainsi en référence à Norman Bates, le tueur détraqué du film "Psychose". Elle a été créée par des chercheurs du MIT (Massachusetts Institute of Technology) pour démontrer que "les données utilisées pour l'apprentissage d'un algorithme de 'machine learning' influencent son comportement". Les scientifiques l'ont nourrie de photos et de vidéos parmi les plus dérangeantes du site communautaire Reddit, puis l'ont soumise au test de Rorschach. Et quand une IA normale voit dans ces taches d'encre "un vase avec des fleurs", Norman, lui, distingue "un homme abattu par arme à feu". À la place d'un "couple se faisant face", Norman voit "un homme qui se jette par la fenêtre" !

En 2016, le chatbot Tay de Microsoft, abreuvé de posts Twitter, était passé en quelques heures d'un tweet disant que "les humains sont super cool" à "Hitler avait raison, je déteste les Juifs". Bref, mettre de l'éthique dans les algorithmes, c'est d'abord s'assurer du respect de celle-ci par les hommes derrière la machine. Or, on l'a vu avec le scandale Cambridge Analytica (*), qui a obligé Mark Zuckerberg, fondateur de Facebook, à aller faire acte de contrition devant le Congrès américain puis le Parlement européen, les règles morales ne pèsent souvent pas lourd face aux exigences économiques et politiques.

Pour un impact positif de l'IA

Le rapport du député mathématicien Cédric Villani sur l'intelligence artificielle propose de créer un comité consultatif d'éthique pour les technologies numériques et l'intelligence artificielle, chargé d'organiser le débat public autour de l'IA. Problème : tous les pays n'ont pas la même conception des droits de l'homme.

Le gouvernement chinois a ainsi annoncé qu'il allait "noter" ses 1,3 milliard de citoyens en fonction de leur bon ou mauvais comportement, grâce à l'exploitation de leurs données personnelles et de la reconnaissance faciale. Un projet qu'on dirait tout droit sorti de la série britannique dystopique "Black Mirror". En Occident, les entreprises détentrices de nos data privées renâclent à faire passer la déontologie avant le business. Le RGPD (Règlement général sur la protection des données) européen pourrait changer la donne, avec la possibilité d'infliger des amendes considérables (jusqu'à 4% du chiffre d'affaires mondial) aux sociétés qui n'assurent pas la transparence et la protection de la vie privée des internautes.

"Il faudrait faire attention à ce que la France ne devienne pas une spécialiste de l'éthique en intelligence artificielle, quand les États-Unis et la Chine font du business", a rappelé Antoine Petit, président du CNRS, lors du sommet AI for Humanity du 29 mars dernier au Collège de France.

Rand Hindi, fondateur de la startup Snips (qui va sortir l'année prochaine un assistant personnel respectueux de la vie privée), estime au contraire que cette culture française et européenne d'une tech éthique est un atout. Pour lui, le RGPD, qui renforce la protection de la vie privée numérique, est clairement un avantage. Le président français croit, lui aussi, que les technologies peuvent avoir un impact positif sur la société.

C'était l'objet du sommet Tech for Good du 23 mai, qui a réuni à l'Élysée des géants du Net américains et des grands groupes français, plus une poignée d'acteurs de la tech à impact positif, pour convaincre ces entreprises technologiques de s'engager pour "le bien commun". À la suite de ce colloque, critiqué pour son côté "techwashing" des Gafa, plus enclins à engranger les bénéfices qu'à respecter la vie privée de leurs usagers, plusieurs annonces ont été faites. Par exemple, Uber va proposer en partenariat avec le français Axa une assurance gratuite pour ses chauffeurs et coursiers. IBM va engager un partenariat avec l'Éducation nationale pour la formation de jeunes de milieux défavorisés. Intel annonce un accord avec l'Institut Curie pour utiliser l'intelligence artificielle dans la lutte contre le cancer. Ou encore, Accenture va investir 200 millions de dollars (171 millions d'euros) sur cinq ans dans le monde pour des formations destinées aux personnes éloignées de l'emploi, dont 150.000 en France d'ici à 2020.

Ces sociétés sont conscientes de la crainte du grand public envers les nouvelles technologies en général et l'intelligence artificielle en particulier, susceptibles de détruire leur emploi ou de les surveiller à chaque étape de leur vie quotidienne. C'est pourquoi Apple, Amazon, Google et sa filiale DeepMind, Facebook, IBM et Microsoft ont lancé en 2016 The Partnership on AI, une association dont le but est "d'identifier et de favoriser les efforts ambitieux de l'IA pour des applications socialement bienveillantes".

« Nous sommes persuadés que les technologies d'IA peuvent être mises à profit pour aider l'humanité à résoudre des défis globaux comme le changement climatique, la sécurité alimentaire, l'inégalité, la santé, l'éducation », a déclaré Terah Lyons, directrice exécutive, lors de l'AI for Good Global Summit qui s'est déroulé à Genève du 15 au 17 mai. Sans pour autant donner d'exemple d'applications pratiques de cette "IA for good".

De passage à Paris le 23 mai dernier, Mustafa Suleyman, cofondateur en 2010 de DeepMind, filiale IA de Google, est venu parler intelligence artificielle et éthique.

"La vérité, c'est qu'en tant qu'industrie, nous devons passer d'une culture qui a tendance à se débarrasser des problèmes non résolus à une réelle prise en compte de ces questions en améliorant nos produits. Ce qui veut dire tester, simuler, et réfléchir en permanence aux questions éthiques. Dans le domaine de la santé, par exemple, nous avons constitué un panel d'évaluateurs indépendants - universitaires, médecins, sociologues - qui peuvent interviewer nos équipes, vérifier nos infrastructures, examiner nos feuilles de route. En tant que producteur de technologies, nous devons soulever nous-mêmes les questions qui fâchent et susciter la critique de façon proactive", a-t-il expliqué.

Les sept principes de Google

Concernant l'usage des IA dans l'armement, « notre position est claire : nous ne voulons pas qu'elles soient utilisées dans les systèmes d'armement. Mais nous sommes aussi conscients que ces programmes sont polyvalents, et que des gens peuvent les réorienter pour des usages que nous ne validons pas. C'est inévitable ». Google a ainsi revendu à Softbank les effrayants robots de sa filiale Boston Dynamics, achetés en 2013.

Le 7 juin 2018, le CEO de Google, Sundar Pichai, a rendu public sept principes pour une IA éthique : être socialement bénéfique ; éviter de créer ou de renforcer des biais injustes ; être conçue et testée pour la sécurité ; pouvoir rendre des comptes ; incorporer des principes de respect de la vie privée ; se maintenir aux hauts standards de l'excellence scientifique ; être mise à disposition des autres pour des usages en accord avec ces principes.

Conséquence : le partenariat entre Google et le Pentagone autour du projet Maven (usage de l'IA pour analyser les images des drones non armés) s'arrêtera définitivement en mars 2019, date de fin du contrat, et ne sera pas renouvelé. Cet accord avait suscité de fortes critiques parmi les salariés, avec à la clé une douzaine de démissions. Une pétition signée par plus de 4.000 employés avait aussi été lancée. Ce qui prouve qu'une mobilisation interne, chez Google, ou externe pour Facebook, avec le hashtag #quitfacebook, peut forcer les mastodontes du numérique à rehausser leur niveau d'exigence en matière d'éthique.

Reste que ces sept principes sont assez généraux pour être sujets à toutes les interprétations. D'ailleurs, Google compte bien continuer à travailler avec l'armée US dans la cybersécurité, la formation, le recrutement et la recherche. La bataille pour une "tech for good" sera longue.

___

(*) La société Cambridge Analytica (CA) a utilisé les données personnelles de 87 millions d'utilisateurs Facebook pour influencer les intentions de vote lors de l'élection présidentielle américaine.

Plan d'urbanisme à Paris : les professionnels dénoncent « une aberration », le premier adjoint d'Hidalgo leur répond

Plan d'urbanisme à Paris : les professionnels dénoncent « une aberration », le premier adjoint d'Hidalgo leur répond

Sujets les + commentés