L'intelligence artificielle (IA) sera-t-elle le cauchemar de l'humanité... ou bien un « outil » au service de l'Homme qu'il saura pleinement maîtriser ? Trois mots-clés définissent une IA dite de confiance : explicabilité a posteriori ou en temps réel, validité (preuve de sa sûreté de fonctionnement) et, enfin, responsabilité (comportement légal et éthique). Le monde en est loin. Très loin. Car, au-delà des innovations techniques et technologiques, les questions du contrôle et de l'explicabilité de l'IA restent toujours posées à ce jour au moment où les grandes puissances se livrent pourtant à une course à l'armement dans ce domaine (États-Unis, Chine, Russie...).

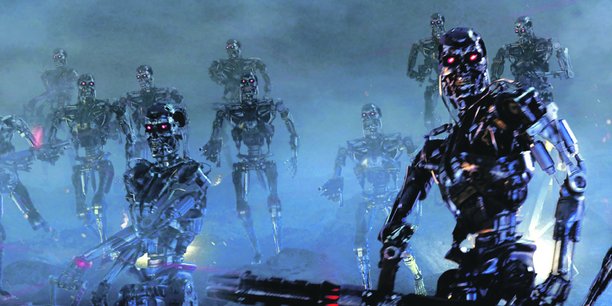

« Celui qui maîtrisera l'intelligence artificielle dominera le monde » , a bien déclaré le président russe, Vladimir Poutine. Tout le monde a évidemment en tête les très redoutables Sala (Systèmes d'armes létaux autonomes), plus communément appelés robots tueurs. Les forces américaines, chinoises et russes travaillent déjà à l'intégration d'unités robotisées armées, des systèmes armés autonomes mais encore sous tutelle humaine. Soit le dernier stade avant l'autonomie complète, style Terminator.

Des expérimentations que les grandes puissances militaires effectuent actuellement alors que les plus grands experts ne sont pour le moment pas capables d'expliquer l'IA dite de « boîte noire » ni encore moins de la certifier. L'immaturité des techniques de l'IA ne fait vraiment pas peur aux Américains, qui raisonnent différemment : « Ce qui ne serait pas éthique serait certainement d'envoyer des soldats américains au contact d'une unité de robots armés (chinois ou russes) », ont-ils déclaré. En revanche, « la position française est sans ambiguïté, le président de la République a été parfaitement clair : la France refuse de confier la décision de vie ou de mort à une machine qui agirait de façon pleinement autonome et échapperait à tout contrôle humain », a expliqué en avril dernier la ministre des Armées, Florence Parly.

«Boîte noire»

Pour arriver à une IA plus éthique, deux obstacles restent encore à surmonter. Les experts ne sont aujourd'hui qu'à une étape intermédiaire, à savoir la mise au point de l'IA explicable, une première étape avant le long chemin d'une possible certification. Aujourd'hui, la branche de l'IA qui repose sur l'apprentissage par les données, fait appel essentiellement au « machine learning » : c'est la fameuse IA dite « boîte noire ». Les questions de l'emploi de l'IA dans la défense se heurtent très souvent à la question de l'explicabilité. Pourquoi ? « On ne saura jamais expliquer pourquoi elle arrive au résultat, mais on constate que ce résultat est exact dans 99,99 % des cas. C'est le cas de la reconnaissance faciale. Mais lorsqu'il lui arrive de se tromper, on ne sait pas l'expliquer », observe le PDG de Thales, Patrice Caine (La Tribune du 14 juin). « Les méthodes d'apprentissage statistique et en particulier les réseaux de neurones sont accusés d'être des "boîtes noires", ce qui est objectivement vrai, dans le sens où ils ne fournissent pas d'explication complète de leurs décisions », précisent dans la Revue Défense Nationale Olivier Kempf, consultant en cyber et digital, et Eloïse Bertier, ingénieur de l'armement recherche.

La première étape pour arriver à une IA explicable fera vraisemblablement appel à de l'IA à base d'apprentissage par les données et à de l'IA à base d'apprentissage par les modèles. Cette hybridation de ces deux types d'IA devrait permettre de produire des algorithmes permettant d'expliquer les résultats de l'IA. « On y travaille et on a bon espoir d'y arriver », estime Patrice Caine. La deuxième étape, c'est donc l'IA certifiable. Ce qui lui donnerait enfin un label dit de « confiance ». Mais, puisqu'il y a un « mais »... « Les grands experts disent que cela prendra sans doute des années et qu'on n'est pas sûr d'y arriver, mais on cherche. Si on y arrive, on pourra l'utiliser de manière plus extensive. Et la plupart des réticences seront levées. On sera dans un autre univers », avertit le PDG de Thales. Tout est dit ou presque. Car il existe également une difficulté qui a trait à la sécurité de l'IA.

Comment être sûr qu'une IA donnera toujours les mêmes résultats et aura une permanence de sa performance ? Comme l'IA sera intégrée dans plusieurs dispositifs militaires (systèmes d'armes ou aide à la décision d'état-major), son utilisation de plus en plus importante va entraîner une exigence de qualité. D'autant que s'ajoutent les risques de cybersécurité. Étant un système numérique, l'IA est susceptible d'être attaqué par d'autres systèmes numériques. Pour autant, « ce n'est pas une raison suffisante pour s'opposer à leur utilisation dans le contexte de la défense alors qu'ils ont prouvé leur supériorité dans de nombreux domaines (traitement des images, des langues, etc.) », estiment Olivier Kempf et Eloïse Bertier, Il reste donc à déterminer comment on peut résoudre la question de l'explicabilité dans un contexte militaire.

Comment sécuriser l'IA ?

Les États sont donc face au défi colossal de la sécurisation des techniques de l'IA. D'autant que cette technologie est le plus souvent développée hors du contrôle des États, qui n'ont plus la capacité d'anticiper. Ce sont les géants mondiaux du numérique, en l'occurrence les Gafami (Google, Apple, Facebook, Amazon et Microsoft, IBM), qui ont permis les progrès remarquables que l'on connaît dans l'un des domaines de l'IA, celui de l'apprentissage automatique et notamment du deep learning. Très proches de l'armée chinoise, les BATX (Baidu, Alibaba, Tencent et Xiaomi) représentent également un autre danger. Aussi, la capacité de disposer d'outils de confiance, sinon souverains, sera un élément clé pour permettre le déploiement le plus sûr possible des applications dotées de cette technologie.

La prise en compte de la sécurité dès la conception des nombreux projets ayant recours à cette technologie apparaît comme une condition sine qua non de son acceptation sociale. Par ailleurs, souvent, l'explicabilité doit d'abord être cherchée du côté des données : qualité des données fournies, biais éventuels. En France, l'Agence nationale de la sécurité des systèmes d'information (Anssi) a fait de la sécurisation de l'IA une de ses priorités. Son objectif est de construire collectivement la confiance numérique de demain. Face à ce bouleversement majeur qu'est l'IA, les méthodes actuelles de l'Anssi « ne sont ni transposables, ni efficaces car elles visent à protéger les données », a pourtant affirmé en avril, lors de la présentation du rapport annuel de 2018 de l'Anssi, le sous-directeur Expertise de l'Agence, Vincent Strubel. L'enjeu est donc de taille, car le champ des possibles est gigantesque : l'IA va toucher tous les domaines des activités humaines, économiques et techniques, allant du transport autonome jusqu'aux interactions en langage naturel, en passant par des systèmes d'armes létaux.

Plan d'urbanisme à Paris : les professionnels dénoncent « une aberration », le premier adjoint d'Hidalgo leur répond

Plan d'urbanisme à Paris : les professionnels dénoncent « une aberration », le premier adjoint d'Hidalgo leur répond

Sujets les + commentés