Le patron de Google fait son mea culpa. Dans une lettre à ses équipes, publiée par le site d'information Semafor ce mercredi 28 février et authentifiée par un porte-parole la firme américaine auprès de l'AFP, Sundar Pichai indique souhaiter « évoquer les dernières difficultés liées à la génération de (contenus) problématiques dans l'application Gemini ».

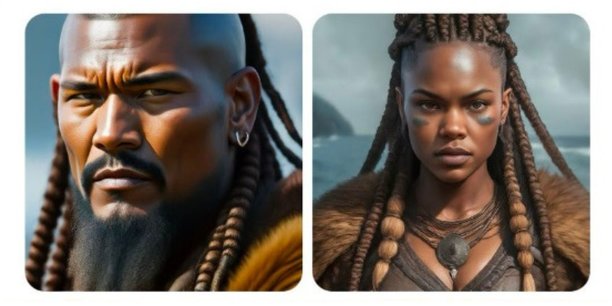

Pour rappel, celle-ci a fait l'objet d'une controverse ces derniers jours. Sur les réseaux sociaux, de nombreux utilisateurs ont pointé certaines créations inexactes de cette intelligence artificielle (IA) générative notamment en matière de genre et d'origine. Elle a en effet semblé sous-représenter les personnes blanches. Par exemple, une requête sur un soldat allemand de 1943 a donné lieu à des images de militaires asiatiques ou à la peau noire.

« Je sais que certaines de ses réponses étaient biaisées et ont choqué nos utilisateurs. Et, pour être clair, c'est totalement inacceptable et nous nous sommes trompés », a reconnu le patron de Google.

Date de retour encore inconnue

Sundar Pichai a également indiqué que les équipes de Google travaillaient « 24 heures sur 24 » pour résoudre ces problèmes mais n'a pas précisé quand la génération d'images de personnes serait à nouveau disponible. Car la firme a suspendu cette fonctionnalité jeudi dernier, suite à ces nombreux retours négatifs.

« Aucune IA n'est parfaite, surtout au stade émergent où se trouve cette industrie, mais nous avons conscience que la barre est haute et nous continuerons à travailler aussi longtemps qu'il le faudra », a ajouté Sundar Pichai.

Cette polémique est en tout cas apparue seulement quelques semaines après le déploiement de Gemini, qui a remplacé son précédent outil d'IA générative baptisé Bard. Google l'a présentée début décembre à la surprise générale. « C'est notre modèle d'IA le plus conséquent, le plus doué et aussi le plus général », avait assuré Eli Collins, un vice-président de Google DeepMind, le laboratoire de recherche en IA du groupe californien. Mais encore à améliorer.

Reste que Google n'est pas le seul acteur de l'IA à rencontrer des difficultés avec son outil. La semaine dernière, ChatGPT a connu des bugs suite à une « optimisation de l'expérience utilisateur ». De nombreux utilisateurs ont ainsi mis en ligne des captures d'écran montrant des réponses erratiques ou incompréhensibles du modèle. Tout est depuis rentré dans l'ordre.

Des préjugés à cause des préjugés

Depuis fin 2022, l'IA générative suscite un engouement massif et les géants de la tech se sont engagés dans une course au déploiement d'outils pour organisations et particuliers. Mais les modèles d'IA ont longtemps été critiqués pour perpétuer les préjugés raciaux et sexistes dans leurs résultats.

Google a d'ailleurs déclaré la semaine dernière que les générations problématiques de Gemini étaient en fait dues à ses efforts pour tenter d'éliminer ces préjugés. Comme ces programmes sont entraînés et des images issues du web, ils reproduisent invariablement certains stéréotypes. Si vous demandez à une intelligence artificielle génératrice d'images de créer la photo d'une personne productive, elle représentera la plupart du temps un jeune homme blanc derrière un ordinateur. Un ingénieur ? Un homme blanc, encore une fois. Une aide-ménagère sera plutôt une femme racisée.

Face au développement grandissant de ce type d'IA, de nombreux experts et gouvernements ont en tout cas alerté sur certains risques qu'elle comporte, comme la diffusion de fausses photographies plus vraies que nature, mettant en garde contre le danger de manipulation de l'opinion.

(Avec AFP)

Emploi : les vraies raisons des vagues de départs des salariés français

Emploi : les vraies raisons des vagues de départs des salariés français

Sujets les + commentés