Même les meilleurs modèles d'intelligence artificielle du monde ont besoin d'humains pour les guider dans leurs décisions. C'est ce que vient de démontrer OpenAI, une entreprise de pointe dans la recherche fondamentale en IA. La startup dispose à la fois de chercheurs de très haut niveau, d'immenses ressources matérielles, et d'un partenariat technique et financier avec Microsoft à hauteur de 1 milliard d'euros. Pourtant, son générateur de texte automatique surpuissant, GPT-2, peut être grandement amélioré avec seulement quelques milliers d'indications données par des humains, a-t-elle expliqué. Voilà une nouvelle preuve que la construction de modèles d'intelligence artificielle doit encore passer par un travail humain, répétitif et onéreux pour s'optimiser. OpenAI se situe encore très loin de son objectif ultime -et incertain- : l'intelligence artificielle générale, capable de reproduire le fonctionnement d'un cerveau humain.

Un générateur de texte bridé contre les fake news

GPT-2, le générateur de texte surpuissant d'OpenAI, se compose de plusieurs briques d'IA, entraînées sur plus de huit millions de pages web. L'utilisateur écrit un paragraphe, la machine complète avec un texte - en théorie - cohérent (vous pouvez tester par vous-même ici). D'après des recherches publiés dans la revue Foreign Affairs, les lecteurs trouvent les textes de GPT-2 presque aussi convaincants que les articles du New York Times écrits par des journalistes. Mais si le résultat moyen est bluffant, le système se rate parfois. Car du côté de la machine, le concept de cohérence n'est pas vraiment similaire.

"GPT-2 fait des rapprochements mathématiques entre ce qu'on lui a écrit et ce qu'il a dans sa base de données. Mais la machine n'a qu'un ersatz du concept de compréhension, elle reste loin de la compréhension humaine" décrypte l'expert en chatbot et vulgarisateur Thomas Gouritin.

À l'annonce du GPT-2 en février 2019, l'entreprise californienne n'a pas publié l'intégralité de son modèle d'IA, comme en elle en a l'habitude. Elle signalait alors craindre des "potentielles utilisations malveillantes de sa technologie". En toile de fond, elle laissait ainsi planer la menace potentielle de campagnes de fake news complètement automatisées. La startup a donc publié des versions bridées de son modèle. Alors qu'il contient 1558 millions de paramètres, OpenAI a d'abord publié une version avec 154 millions de paramètres, puis une version intermédiaire en mai et enfin, le 20 août 2019, une version avec 774 millions de paramètres. Soit moitié moins que le modèle complet.

"Il manque une brique quelque part, mais on ne sait pas où"

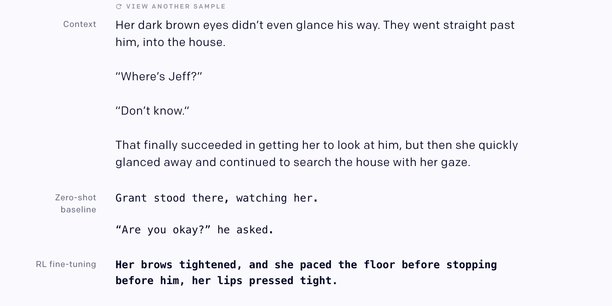

Dans son dernier article, publié le 19 septembre, OpenAI expose les résultats de son essai d'"ajustement" de la version 774M de GPT-2. Concrètement, l'entreprise a payé pour que des humains évaluent les résultats de la machine :

"Les travailleurs donnent des scores aux résultats issus de la machine et qui leur sont présentés. Ils indiquent ainsi les meilleures versions et le modèle s'enrichit de ces nouvelles informations", résume Thomas Gouritin.

L'emploi de travail humain pour étiqueter les données est souvent éludé, voire dissimulé, quand les logiciels d'intelligence artificielle sont présentés. Pourtant, il est souvent essentiel à leur développement. Un rapport du projet Digital Platform Labor (DiPLab), mené par Télécom ParisTech et le CNRS, affirmait que 260.000 personnes effectuaient occasionnellement ce type de mission en France.

Plus précisément, les chercheurs ont tenté d'améliorer deux tâches que GPT-2 peut effectuer. La première, la "continuation stylistique de texte" permet de donner des indications quant à l'écriture du texte qui sera généré automatiquement. L'utilisateur peut par exemple demander qu'il soit écrit pour refléter "un sentiment positif". OpenAI a introduit 5.000 étiquetages faits par des humains, et obtenu un résultat préféré à celui du modèle de base dans plus de 85% des cas.

Pour la deuxième tâche, qui consiste à résumer un texte, l'ajustement a été plus de laborieux. Les chercheurs ont fait appel à 60.000 indications faites par des humains. Problème : si la version ajustée s'avère très souvent correcte dans le résumé, alors que la version de base se rate souvent, c'est aussi parce qu'elle copie directement des phrases du texte qu'elle doit condenser.

"Nos résultats sont mitigés : pour les continuations, nous avons de bons résultats avec peu d'échantillons, mais nos modèles de résumés sont simplement des "copieurs intelligents" : ils copient le texte d'entrée, mais zappent la partie non pertinente du préambule", écrivent les auteurs du texte.

Autre écueil de cet ajustement : il a complexifié le modèle, et rend à la fois son amélioration et sa vérification plus difficiles. Et malgré tout cela, il est encore très loin d'atteindre le niveau de performance d'un humain dans ses tâches d'écriture.

"Le fait d'avoir toujours plus de ressources et de capacité de calcul permet d'améliorer sans cesse les modèles. Mais on reste toujours dans une simulation d'écriture, pas une compréhension fine du langage par la machine. Pour y arriver, on sait qu'il faut rajouter une brique quelque part, mais on ne sait pas exactement où. Une des idées vise à doter les algorithmes d'une dose de bon sens, et les chercheurs explorent déjà plusieurs pistes pour y parvenir", conclut Thomas Gouritin.

Dette : « La signature de la France reste très forte » (Aurore Lalucq, députée européenne) (37)

Dette : « La signature de la France reste très forte » (Aurore Lalucq, députée européenne) (37)

Sujets les + commentés