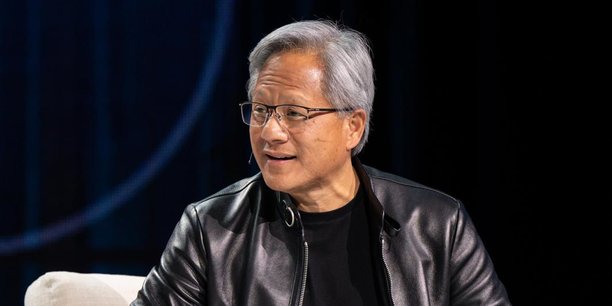

« Il s'agit de la plus grosse révolution dans l'histoire de l'informatique : des ordinateurs capables d'écrire du logiciel pour d'autres ordinateurs. Le tout à l'aide d'une interface extrêmement facile à utiliser, à laquelle on peut confier à peu près n'importe quelle tâche, le tout en s'exprimant en langage naturel. » Ainsi parlait Jensen Huang, le patron de Nvidia, lors de la conférence annuelle de l'entreprise Snowflake qui se tenait cette semaine à Las Vegas.

Venu sur scène pour présenter le nouveau partenariat de son entreprise avec le spécialiste de la gestion des données dans le cloud, il a, à plusieurs reprises, insisté sur le saut quantique que représente selon lui l'intelligence artificielle générative.

« Nous vivons le premier changement de plateforme dans l'informatique depuis cinquante ans : la technologie a bien sûr évolué, mais les bases sont restées les mêmes. Cette nouvelle manière d'écrire du logiciel nous entraîne dans un paradigme totalement différent », a martelé le dirigeant.

L'IA générative fait les choux gras de Nvidia

Il faut dire que la vague de l'IA générative a déjà fortement bénéficié à Nvidia. Le cours de l'action de l'entreprise a connu une hausse vertigineuse de 200% depuis le début de l'année, portant sa valeur de marché à plus de 1 000 milliards de dollars, un record historique. Au premier trimestre, son chiffre d'affaires s'est accru de 14% d'une année sur l'autre. Au deuxième, il pourrait battre les estimations de Wall Street de plus de 50%.

Des performances que les analystes et le management de Nvidia attribuent notamment à l'enthousiasme suscité par les possibilités de l'IA générative. Celui-ci entraîne une ruée vers les unités de traitement graphiques (ou graphic processing units, GPUs, par opposition aux central processing units ou CPUs, les microprocesseurs traditionnels), utilisées pour l'intelligence artificielle, et sur lesquelles Nvidia détient une part de marché de 88%, selon Jon Peddie Research, un cabinet de recherche en informatique.

En effet, l'entraînement des grands modèles linguistiques, sur lesquels repose l'intelligence artificielle générative, est particulièrement gourmand en puissance informatique, et donc en GPUs. Pour entraîner ChatGPT, pas moins de 10.000 GPUs de Nvidia ont été nécessaires, utilisées sur plusieurs semaines. Or, les géants du cloud comme Google, Microsoft et Amazon multiplient les investissements dans cette technologie, vue comme l'un des relais de croissance les plus prometteurs sur un marché des nouvelles technologies plutôt morose. Dans ce contexte, les produits de Nvidia s'arrachent comme des petits pains.

Rapprocher le calcul des données

Pour le patron de Nvidia, tirer tous les bénéfices de l'IA générative ne requiert pas seulement plus de puissance informatique, mais aussi de rapprocher le calcul et les applications des données, ce que l'on nomme l'informatique en périphérie ou edge computing, et qui justifie son partenariat avec Snowflake.

« Historiquement, on déplaçait les données vers les ordinateurs, car il y avait peu de données à déplacer. Mais aujourd'hui, à l'heure du traitement des masses de données, celles-ci possèdent une gravité importante, d'autant que les régulations encadrant leurs déplacements se multiplient. Il est donc plus simple pour nous de rapprocher nos machines de calcul des données stockées dans Snowflake. La puissance des grands modèles linguistiques permet ensuite de générer automatiquement des applications à partir des données », explique le dirigeant.

Inversement, la pénurie de GPUs freine les ambitions des acteurs du cloud, toujours en quête de davantage de puissance informatique pour offrir la fameuse élasticité promise à leurs clients. « Il est aujourd'hui pratiquement impossible d'obtenir rapidement plus de 16 GPUs mises en réseau dans le cloud public, à moins de payer un prix astronomique. En outre, le temps d'attente pour la nouvelle unité de traitement graphique de Nvidia H100 est énorme, plus de huit mois pour un déploiement à grande échelle », nous confiait récemment Dylan Patel, analyste chez SemiAnalysis, un cabinet spécialisé dans la recherche sur les puces.

Pour Snowflake, un partenariat avec Nvidia est donc une très bonne affaire à cet égard. AMD, rival de Nvidia, a de son côté récemment annoncé de nouvelles GPUs pour répondre à la hausse de la demande et venir concurrencer Nvidia sur son propre terrain.

Une usine d'IAs pour chaque entreprise

Jensen Huang envisage un futur dans lequel, grâce à l'analyse des masses de données, chaque entreprise aura une bien meilleure vision de sa situation et pourra donc répondre de manière beaucoup plus efficace aux attentes du marché.

« Il sera bientôt possible d'entraîner de grands modèles linguistiques sur sa base de données clients et ainsi d'engager un dialogue avec ses données : qu'est-ce que nos clients apprécient le plus dans nos produits, qu'est-ce que l'on pourrait améliorer, comment... Il sera possible de poser toutes ces questions et d'obtenir des réponses précises », prédit le dirigeant de Nvidia.

Selon lui, chaque entreprise possédera ainsi un grand nombre d'intelligences artificielles calibrées pour résoudre des problèmes bien spécifiques. « Chacun aura sa propre usine à intelligences artificielles qui travailleront 24h/24 pour exploiter la mine d'or que constituent les données. »

Un avis que partage Jeff Holan, directeur gestion des produits chez Snowflake, pour qui les modèles généralistes comme ChatGPT serviront de base pour construire des modèles plus spécialisés. « La plupart des entreprises n'ont pas accès aux meilleurs ingénieurs des données ni à la puissance informatique nécessaire pour entraîner des modèles linguistiques de A à Z, mais elles peuvent prendre des modèles généralistes existants et les ajuster pour coller à leurs besoins. »

En sachant que les usages les plus révolutionnaires de l'IA générative n'ont selon lui pas encore été inventés. « Aux débuts de l'Internet, l'un des premiers usages à se mettre en place a été les e-mails, qui n'étaient qu'une transposition virtuelle et plus efficace de quelque chose qu'on faisait déjà dans le monde physique. Il a fallu quelques années pour qu'émergent les sites web, le e-commerce, les réseaux sociaux... De même, l'IA générative s'incarne pour le moment dans les chatbots, car c'est quelque chose que nous connaissons déjà. Mais il est probable que dans le futur, ils ne représentent qu'une infime portion des applications de cette technologie. »

Nucléaire : après 12 ans de retard, EDF va enfin mettre en service l’EPR de Flamanville

Nucléaire : après 12 ans de retard, EDF va enfin mettre en service l’EPR de Flamanville

Sujets les + commentés